Viele Unternehmen treffen heute immer noch wesentliche Entscheidungen aus dem Bauch heraus oder auf der Basis klassischer Business Intelligence, also aufgrund von Erfahrungen, die sich mithilfe historischer Daten begründen lassen. In Zeiten der Digitalisierung reicht dies allein nicht mehr aus, um als Unternehmen erfolgreich zu sein. Erfolgreiche Unternehmen wie Facebook oder Netflix gewinnen Informationen und Erkenntnisse heute auf innovative Weise aus vielfältigsten Daten und fällen auf dieser Grundlage ihre Entscheidungen. Sie entscheiden also „datengetrieben“. „“ „Datengetrieben“ bedeutet, Erkenntnisse zu gewinnen durch eine konsequent ganzheitliche Betrachtung aller zur Verfügung stehender Daten und dem Einsatz geeigneter intelligenter Analysemethoden. Das Ziel sind bessere Entscheidungen und die Optimierung der eigenen Wertschöpfungsprozesse, um die Wettbewerbsfähigkeit des Unternehmens nachhaltig zu verbessern. Teilweise entstehen durch diese Erkenntnisse auch neue und zum Teil disruptive Geschäftsmodelle. Für manche Unternehmen ist dies heute die einzige Chance, ihr Überleben langfristig zu sichern.

Was bedeutet es „datengetrieben“ zu sein?

Dieses oben geschilderte Verständnis von „datengetrieben“ geht sogar noch darüber hinaus, was üblicherweise als Definition angesehen wird, nämlich der reine Übergang vom Bauchgefühl zur Begründung von Entscheidungen mit Daten: „The adjective data-driven means that progress in an activity is compelled by data, rather than by intuition or by personal experience.“ [1] Die meisten DWH- und BI-Systeme, die seit Mitte der 90er Jahre in vielen Unternehmen aufgebaut wurden, sind in der Regel auf Auswertungen von fachlich konsolidierten, historisierten Daten ausgelegt (klassische BI). Diese stellen gut aufbereitete Informationen über die Entwicklung und Zusammenhänge von Vergangenem zur Verfügung, wodurch das Bauchgefühl für anstehende Entscheidungen abgesichert wird. Diese rückwärtsgerichtete Datenanalyse reicht heute nicht mehr aus. Es bedarf vor allem einer deutlich optimierten Basis von Daten, geeigneter Tools und Methoden zur Analyse, und eine darauf abgestimmte Organisation. Damit einhergehen muss gleichfalls ein Kulturwandel im Umgang mit den Daten.

Datengetrieben zu arbeiten hat seinen Vorteil. Diverse Untersuchungen aus den letzten Jahren, deuten darauf hin, dass datengetriebene Unternehmen erfolgreicher sind, weil sie …

- … informierter sind und somit bessere Entscheidungen treffen.

- … ihre Prozesse kennen und optimiert haben, was sich z. B. in schnelleren Produktionszeiten, höherer Qualität oder einfach geringeren Stückkosten zeigt.

- … Entscheidungen zunehmend automatisieren (und damit auch beschleunigen) können.

- … Risiken und Veränderungen im Markt frühzeitig erkennen und rechtzeitig sowie zielgerichtet darauf reagieren können.

- … konkret Mehrwerte aus ihren Daten generieren, indem z.B. neue Geschäftsmodelle darauf aufgebaut werden (bspw. Monetarisierung von IoT-Daten aus verkauften Maschinen)

In vielen Unternehmen werden die entstehenden Daten nur selten vollumfänglich genutzt. Dabei bezieht sich „vollumfänglich“ sowohl auf die Breite (alle Daten werden genutzt), als auch auf die Tiefe (vielfältigste Anwendungsfälle werden optimal unterstützt). Was also benötigen nun Unternehmen, um sich ausgehend von klassischer BI weiter in Richtung eines datengetriebenen Unternehmens zu entwickeln?

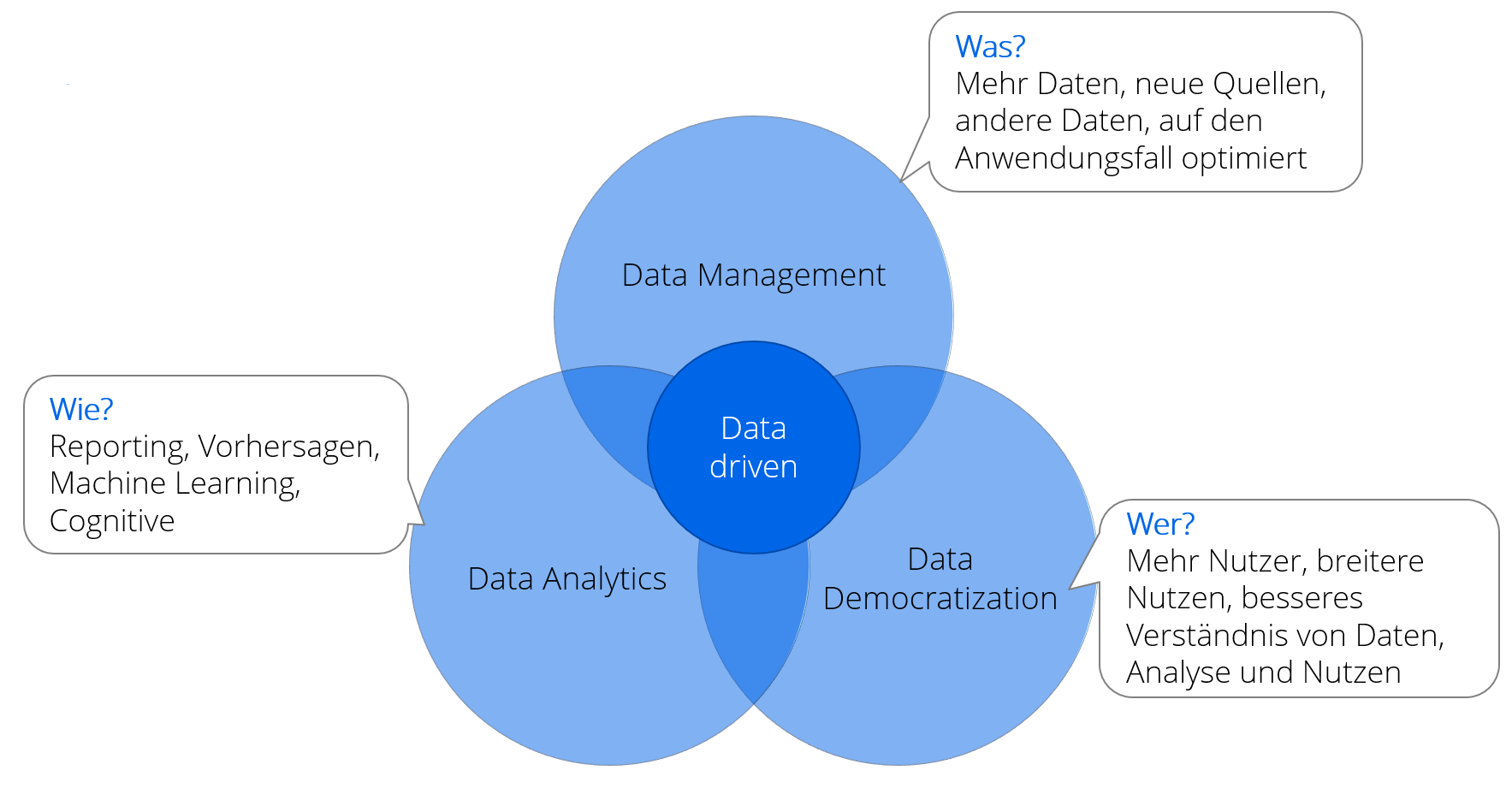

Aus unserer Sicht sind für die Entwicklung eines datengetriebenen Ansatzes drei Themenfelder wichtig (siehe auch Abb. 1):

- Data Management (Wie kann ich mehr Daten nutzen?)

- Data Analytics (Wie kann ich die Daten besser nutzen?)

- Data Democratization (Wie können Daten von mehr Personen genutzt werden?)

Im Folgenden und in den zwei weiteren Teilen dieser Blogpost-Serie wollen wir auf diese drei Themenfelder genauer eingehen und abschließend auch auf den Weg zu datengetriebenem Arbeiten eingehen.

Data Management, oder: Wie kann ich mehr Daten nutzen?

Durch die zunehmende Digitalisierung nimmt die insgesamt zur Verfügung stehende Datenmenge immer mehr zu, einzelne Schätzungen rechnen mit einer Verzehnfachung der Datenmenge alle 5 Jahre auf insgesamt über 175 Zettabyte im Jahr 2025 [2]. Auch die Heterogenität der Formate, in denen die Daten gespeichert sind, nimmt zu: Die Bandbreite der Formate reicht von relational oder semistrukturiert (z. B. JSON oder XML) bis zu ganz anderen Informationsträgern wie Videos, Texten oder Bildern.

Neben unternehmensinternen Daten hat die Verwendung von externen Datenquellen in den letzten Jahren deutlich zugenommen: frei verfügbare Datenquellen (OpenData), aber auch der immense Datenpool aus Social-Media-Plattformen wie Twitter oder Facebook sowie die zunehmend verfügbaren Sensordaten zum Beispiel aus Maschinen in der Produktion oder intelligenten Produkten.

Daraus ergeben sich vielfältige Herausforderungen: Auf der technischen Seite ist das zum Beispiel die Frage nach der richtigen Architektur. Hierbei gilt es, aktuelle Themen wie Big Data, Data Lake, Data Vault, Automatisierung und Cloud bestmöglich mit einzubeziehen. Cloud-basierte Ansätze mit hybriden Architekturen bieten hier Vorteile, weil vorhandene Systeme weiter genutzt werden (Investitionsschutz), gleichzeitig aber auch die Erweiterung um aktuelle Technologien und Ansätze und die Umsetzung neuer, innovativer Anwendungsfälle sichergestellt werden kann. So können z.B. Management und Integration von IoT-Daten oder Streaming-Anwendungsfälle von Beginn an in der Cloud umgesetzt werden. Der Cloud-basierte Ansatz gewährleistet darüber hinaus, einfache Skalierbarkeit der Systeme, um möglichst flexibel und effizient mitwachsen zu können. Auf der organisatorischen Seite zeigt sich, dass mit zunehmender Datenmenge auch die Handhabung der Daten umfangreicher und komplexer wird. Aus diesem Grund ist eine klare Datenstrategie mit entsprechenden Leitplanken und einer expliziten Daten-Governance unabdingbar.

Mehr und vielfältigere Daten bedeuten zwar in der Theorie mehr Nutzen, allerdings bringt die reine Speicherung von Daten noch keinen Mehrwert. Bei der Erschließung neuer Datenquellen ist folglich eine Fokussierung auf konkrete nutzenbringende Anwendungsfälle wichtig. Bei einer solchen anwendungsfallbasierten Erweiterung der Systeme, bietet es sich an, agile Vorgehensweisen zu nutzen und bei der Umsetzung der Vorhaben einzusetzen. Mit steigender Datenmenge werden auch die Themen Datenqualität ([3]), Master- und Metadatenmanagement wichtig. Viele neue Daten nutzen nichts, wenn sie nicht die zur Analyse benötigte Qualität besitzen. Ein Programm zum Management der Datenqualität ist irgendwann unabdingbar, genauso wie ein ordentliches Management der Metadaten, um in der steigenden Datenmenge nicht den Überblick zu verlieren. Hier bietet sich die Einführung eines Metadatenkataloges an, in dem nicht nur gespeichert wird, welche Daten wo zu finden sind, sondern auch Verantwortlichkeiten für Daten und welche Daten wie und von wem genutzt werden.

Die Beschäftigung mit neuen und mehr Daten alleine ist allerdings nicht ausreichend. Zusätzlich sollte man sich auch Gedanken machen, auf welche Art und Weise diese Daten ausgewertet werden und wie mehr Personen in ihrem Unternehmen die Ergebnisse nutzen können. Über diese beiden weiteren Themenfelder (Data Analytics und Data Democratization) und die konkrete Ausgestaltung des Weges zum datengetriebenen Unternehmen lesen sie mehr in Teil 2 und Teil 3 dieser Blogpost-Serie.

Literaturhinweise zu diesem Blogpost:

[1] https://en.wikipedia.org/wiki/Data-driven, abgerufen 23.3.2020

[2] Reinsel, D. / Gantz, J. / Rydning, J.: Data Age 2025 – The Digitization of the World – From Edge to Core. IDC Whitepaper, November 2018. https://www.seagate.com/files/www-content/our-story/trends/files/idc-seagate-dataage-whitepaper.pdf

[3] Apel, D. et al.: Datenqualität erfolgreich steuern: Praxislösungen für Business-Intelligence-Projekte. Hanser Verlag 2009